Perspectivas de la inteligencia artificial

Una vez finalizado el año 2001, voy a hacer un ejercicio de reflexión y revisión de la inteligencia artificial, sus realidades y perspectivas actuales, utilizando como apoyo las prestaciones del computador Hal, un protagonista “especial y espacial” de una famosa película.

Recuerdo que en 1968, cuando se estrenó la película 2001: Una odisea en el espacio, yo me encontraba estudiando los primeros cursos de bachillerato, y me impactó la primera vez que la vi. Reconozco que en ese momento no entendí su sentido filosófico, pero en la ficción que planteaba aparecían muchas cosas que como explicaré, despertaban cierta inquietud en los que la veíamos: un computador inteligente por cuanto que poseía capacidades de percepción, razonamiento, reacción y consciencia. No pensaba yo, cuando estaba viendo esta película por primera vez, que a fecha de hoy estaría escribiendo apoyándome en ella para plantear lo alcanzado y lo pendiente, en cuanto a la Inteligencia Artificial y su vertiente aplicada.

Desde hace siglos, el ser humano ha intentado construir máquinas que realicen sus tareas más rutinarias o más peligrosas tratando de imitar su comportamiento y el del resto de los seres vivos. Así se diseñaron máquinas de calcular que ahorraban mucho tiempo al usuario y cometían menos errores. Dentro de esta línea se desarrollaron autómatas que imitaban comportamientos de animales, con apariencia de humanos y máquinas de jugar a diversos juegos, como el ajedrez o las damas.

Sin embargo, no es hasta la aparición del transistor, y más concretamente de las computadoras, cuando se empieza a hablar de máquinas inteligentes. Cuando la película 2001 fue estrenada, un crítico la calificó como «el sueño mejor informado» del futuro, refiriéndose al computador HAL.

Antes de usar el término Inteligencia Artificial (IA) deberíamos precisar qué entendemos por inteligencia. La Real Academia de la Lengua Española nos define la inteligencia como “potencia intelectual: facultad de conocer, de entender o comprender”. Pero, ¿cómo se modifica el concepto cuando se añade el calificativo de artificial?.

A los efectos de este artículo, voy a utilizar la definición de Inteligencia Artificial que pienso es más ajustada a la realidad actual. La propuso Marvin Minsky, uno de los pioneros de la IA, y dice así: “La Inteligencia Artificial es la ciencia de construir máquinas para que hagan cosas que, si las hicieran los humanos, requerirían inteligencia”.

La Inteligencia Artificial toma un sentido científico viable, como disciplina informática moderna, durante la segunda mitad del siglo pasado, y es el resultado directo de la confluencia de diversas corrientes intelectuales (Teoría de la Computación, Cibernética, Teoría de la Información, Procesamiento Simbólico) desarrolladas sobre los cimientos formales de la Lógica y la Matemática Discreta, e impulsadas por el desarrollo de los ordenadores digitales.

Caracterización de la Inteligencia Artificial

Para caracterizar la Inteligencia Artificial, Alan Turing propuso un test que, caso de que una máquina lo pasara, nos indicaría cuándo dicha máquina se podría considerar tan inteligente como un humano. Este test consiste en situar a un humano y a una máquina en dos salas distintas. El juez u observador debe realizar una serie de preguntas a ambas salas, sin saber de antemano en cuál de las dos se encuentra la máquina, tratando de averiguar qué sala es la del humano y cuál la de la máquina. Cuando la probabilidad de no adivinar la sala de la máquina sea alta, es decir, cuando el juez no pueda distinguir por las respuestas qué sala se corresponde con la de la máquina, estaremos ante una máquina que se podría considerar como un humano, en su interacción conversacional.

Posteriormente Searle, en 1980, propuso un contraejemplo al test de Turing, donde podemos encontrar una máquina que pase dicho test y, sin embargo, no sea inteligente, o sea, no comprenda lo que está haciendo. A este ejemplo se le denominó la Sala China y consiste en situar en una sala a un humano que únicamente conoce el idioma inglés. Este humano dispone de un manual perfecto de traducción del chino al inglés, pero el humano no sabe que los símbolos del manual son chinos, ni siquiera sabe lo qué está haciendo. Sigue un libro de reglas. El humano simplemente debe recoger unos papeles que le llegan por una ventana los cuales contienen una serie de símbolos que no reconoce y, utilizando el manual, devuelve a continuación una respuesta por la ventana. Un observador fuera de la sala pensaría que lo que hay en dicha sala comprende el chino, ya que traduce textos del chino al inglés, pero la persona que está en su interior no tiene consciencia de ese conocimiento del chino. Por ello, una máquina que pasara el Test de Turing no es necesariamente consciente de lo que está haciendo, algo necesariamente unido a los humanos.

Se han empleado múltiples argumentos para situarse en una u otra posición, esto es, la de los que piensan que una máquina puede llegar a ser consciente y la de los que piensan que la consciencia está reservada a los humanos. Voy a dejar a propósito abierta esta cuestión para que alguno de ustedes medite acerca de ella, y como decimos los profesores, cuando quieran hablamos de esto.

El contexto histórico y tecnológico en que se concibió HAL(6468)

El 6 de Abril de 1968 Kubrick y Clarke estrenaron la película 2001: Una odisea en el espacio. Versa en clave de ficción sobre el destino del hombre, su papel en el cosmos y su relación con más altas formas de vida. Los autores ubican en el 2001, el lanzamiento de una nave a estos efectos.

El sexto miembro de la tripulación de la nave en la cual transcurre gran parte de la trama es el computador HAL 9.000, “cerebro y sistema nervioso de la nave”. HAL (siglas en inglés de computador Algorítmico Heurísticamente programado).

Kubrick y Clark trabajaron en el guión de 2001 entre 1964 y 1968, las prestaciones de HALno eran pura ficción, sino resultado en buena parte de un riguroso trabajo de recopilación de expectativas y previsiones de lo que podrían alcanzar los computadores y la Inteligencia Artificial (IA) en los siguientes 30 años.

De hecho, para documentarse entrevistaron a los científicos más relevantes de la época. Entre otros, Minsky les mostró las instalaciones de experimentación en el MIT (Instituto Tecnológico de Massachussets).

Veamos qué había ocurrido en los años previos al 64. Entre 1951 y 1964 se produjeron los primeros computadores, mostrando ya una rápida evolución en esos primeros catorce años. En el año 1956 se realizó la histórica Conferencia de Dartmouth. En ella, una nueva generación de investigadores (Minsky, McCarthy, Newell, Simon, Samuel, Rochester, Shannon, Solomonoff, Selfridge y More) definen las directrices y líneas de actuación futuras en el ámbito de la IA, tomando como hipótesis de trabajo la proposición: “Todo aspecto de aprendizaje o cualquier otra característica de inteligencia puede ser definido de forma tan precisa que puede construirse una máquina para simularlo”. Esta hipótesis sería posteriormente conocida como Hipótesis del Sistema de Símbolos Físicos. De esta conferencia se derivó un estado eufórico, propio por otra parte del comienzo de cualquier tecnología novedosa, que propicia aseveraciones desmesuradas y prometedoras en exceso: Se predecía que al cabo de 25 años los ordenadores harían todo el trabajo de los hombres. Dentro de esta línea, en 1958, Newell y Simon aseguraban que en menos de 15 años un ordenador sería campeón mundial de ajedrez.

Por otro lado, en la etapa de escritura y realización del film 2001, la tecnología ganaba protagonismo rápidamente apoyada en el continuo progreso de los computadores. En 1969, se dio el primer paso del ser humano en la luna. Se daba así un buen caldo de cultivo para predecir a Hal, en poco más de 30 años.

Características de Hal

Pero, ¿Cómo es Hal? En la película 2001, es una máquina inteligente que podía reproducir la mayoría de las actividades del cerebro humano, y con mucha mayor velocidad y seguridad. Incluso con excesiva seguridad, asegura que su serie nunca se había equivocado.

HAL había sido entrenado para aquella misión tan esmeradamente como sus colegas humanos… y a un grado de potencia mucho mayor, pues además de su velocidad intrínseca, no descansaba nunca. Su primera tarea era mantener en su punto los sistemas de subsistencia, comprobando continuamente la presión del oxígeno, la temperatura, el ajuste del casco, la radiación y todos los demás factores inherentes de los que dependían las vidas del frágil cargamento humano.

Podía planificar y decidir las intrincadas correcciones de navegación y ejecutar las necesarias maniobras de vuelo cuando era el momento de cambiar de rumbo. Y podía atender a los hibernadores, verificando cualquier ajuste necesario a su ambiente, y distribuyendo las minúsculas cantidades de fluidos intravenosos que los mantenían con vida.Sihanvistoovenlapelícula,convendrán conmigo: ¡Excesiva responsabilidad!

HAL se comunicaba con sus compañeros humanos de la nave mediante la palabra hablada. Los humanos podían hablar a HAL como si también fuese un ser humano, y él contestaba en el más puro y perfecto español (inglés) que había aprendido durante las fugaces semanas de su infancia electrónica.

Los tripulantes humanos se habían referido a menudo humorísticamente a sí mismos como celadores o conserjes a bordo de una nave que podía realmente valerse por sí misma. Se hubieran asombrado mucho, y su indignación hubiera sido grande, al descubrir cuanta verdad contenía su chanza.

Por todo ello, podemos considerar que HAL pasaría sin dificultades el test de Turing y su comportamiento revela altos niveles de consciencia.

Realidades en el 2001 de HAL

Volviendo al momento actual, desde la perspectiva científica y tecnológica, podemos hacernos una serie de preguntas sobre Hal:

¿Qué funcionalidades y en qué grado han sido alcanzadas a fecha de hoy?, hagamos un repaso por distintos campos.

En el ajedrez por computadora, se comenzó tratando de reproducir los métodos de maestros de ajedrez humanos (como reconocer configuraciones particulares claves en el tablero). Pero en computadoras las búsquedas masivas y rápidas de sucesiones posibles de movimientos tienen más éxito. Este enfoque se usa en Deep Blue, las capacidades de búsquedas rápidas son su diferencia frente a los maestros humanos.

Deep Blue de IBM jugó frente a Gary Kasparov en el mes de febrero de 1996 ganándole en algunas partidas. Actualmente Deep Blue se puede considerar que tiene un nivel de juego que le permite ganar partidas a cualquier jugador humano. Los objetivos del proyecto Deep Blue eran desarrollar una máquina capaz de jugar en el nivel del campeón mundial de ajedrez y aplicar el conocimiento obtenido en este trabajo para resolver otros problemas complejos. Hoy Deep Blue es capaz de procesar hasta doscientos millones de posiciones de ajedrez por segundo. Por su habilidad de buscar tal extraordinario número de posiciones, Kasparov comentó que «la cantidad había llegado a ser la calidad».

Hablemos de la Síntesis de Sonidos. La voz de HAL era otro aspecto novedoso. Antes de HAL, el sonido “metálico” era la indicación para el espectador de que hablaba una computadora o robot. 2001, sin embargo, representó una forma diferente de hablar las computadoras, HAL habla con sonidos y tonos absolutamente humanos incluso con voz emocional. Cuando se hizo 2001, la síntesis de voz por computador era exclusivamente “metálica”.

Actualmente, se usan dos tipos de parámetros para la síntesis: las formas de ondas almacenadas y un conjunto pequeño de parámetros espectrales que se deriva matemáticamente de la señal del habla. Estos sistemas producen habla de alta calidad y son de gran ayuda para ciegos. Aunque trabajen adecuadamente para expresiones cortas o palabras aisladas, con oraciones no pueden transmitir las sutilezas humanas del énfasis y la entonación. Para ello el computador requiere entender lo que dice, un problema extremadamente duro y no resuelto.

También eran novedosos los sentimientos y la forma de cantar de HAL. En la trama de 2001, antes de ser desconectada totalmente, HAL empieza a cantar, rememorando lo que para “ella” eran aprendizajes de su “infancia”. La canción que escoge es curiosa. Dudo que mucha gente pensara en una canción de cuna como la canción apropiada para esta escena. Sin embargo, cuando Clarke la escogió, esta canción ya era importante históricamente: era la primera canción jamás cantada por una computadora. Este trabajo ya había sido hecho por John Kelly en los laboratorios de Bell.

Otra característica de HAL es el Reconocimiento del Habla. Se han realizado avances importantes hacia el reconocimiento automático del habla, especialmente en las etapas iniciales de transcribir el sonido crudo en fonemas. Actualmente existen sistemas comerciales de reconocimiento del habla. Y no nos resulta llamativo que en los teléfonos móviles podamos dar ordenes por voz.

El reconocimiento general del habla, sin embargo, depende fuertemente del sentido semántico y común, del conocimiento del contexto y del mundo. El conocimiento va más allá de hechos y meros datos. Para que la información llegue a ser el conocimiento, debe incorporar las relaciones entre ideas. Y para que el conocimiento sea útil, los eslabones que describen cómo actúan los conceptos recíprocamente, deben ser accesibles, actualizados y manipulados fácilmente. La inteligencia humana es notable en su habilidad de realizar todas estas tareas. Irónicamente también, es notablemente débil en almacenar la información en la que se basa el conocimiento. Las prestaciones de las computadoras actuales se basan exactamente en lo contrario. Manejan información en cantidad y velocidad, pero muestran grandes dificultades para tratar el conocimiento.

Para ello, el reconocimiento del habla actualmente tiene que ser integrado con otros niveles y fuentes del conocimiento. Por ejemplo, se dispone de sistemas que integran su capacidad de reconocimiento del habla de un gran vocabulario con un sistema experto que tiene conocimiento extenso acerca de la preparación de informes médicos.

Otro aspecto de HAL es la visión. Una computadora tan avanzada como HAL se esperaría que tuviera las capacidades visuales y cognitivas bien desarrolladas: podría comprender escenas visuales, ver y leer el movimiento de los labios… ¿Se puede programar realmente una computadora para hacer tales cosas? El campo de la visión por computadora aborda los métodos que podemos usar con un computador para obtener información acerca de objetos y acontecimientos en una escena analizando las imágenes de la escena. Exploramos qué información acerca de las partes se puede usar para el reconocimiento, por ejemplo, identificar cierta cara de persona en una colección de imágenes. Para reconocer las expresiones faciales de personas se pueden usar variaciones en la apariencia de partes de una cara sobre una sucesión de imágenes. Actualmente hay procesos visuales que los realiza mejor un computador que el ser humano (sobre todo los que tienen que ver con la agudeza visual) pero los procesos vinculados a la compresión de escenas en forma general resultan, imposibles hoy por hoy para los sistemas artificiales.

Otra pregunta: ¿Qué funcionalidades no han sido alcanzadas?

La investigación en el reconocimiento de la emoción por computadora y la expresión de la emoción está en su infancia. Por ejemplo, el reconocimiento de la expresión facial y la síntesis del afecto en la voz. Estas no son, por supuesto, las únicas maneras de reconocer los estados emocionales: la postura y los signos fisiológicos, como gestos y tasa aumentada de respiración, por ejemplo, proporcionan también indicaciones valiosas a tal fin.

HAL muestra emociones, en una ocasión especial dice: «Tengo miedo. Tengo miedo. Pierdo mi mente. No puedo sentirme”. Las emociones de HAL (su orgullo, la cólera, el temor, la paranoia..) constituyen ámbitos no explorados formalmente en la IA.

¿HAL es posible hoy?. Ciertamente no con la tecnología actual. ¿La comprensión del habla? No totalmente. ¿Mentir? Rotundamente no: eso requiere la inteligencia emocional y comprensión muy avanzada. A fin de cuentas, decir una mentira requiere saber lo que la otra persona es probable que crea, confeccionar un cuento creíble que sirva para las circunstancias, y modificarlo según se requiera. En humanos, lleva años desarrollar las habilidades apropiadas: los bebés no lo pueden hacer y los niños lo hacen generalmente con torpeza. Pero HAL, con su inteligencia superior, según cabe suponer, miente brillantemente, como se constata en una parte de 2001.

Y por último: ¿Qué elementos tecnológicos actuales no se contemplaron en HAL?

Es un descendiente directo de las computadoras del principio “lo más grande es mejor”, de la tecnología que comenzó en los 40´s con ENIAC. Las computadoras serían más y más grandes así como también cada vez más potentes. Los guionistas y los consejeros de 2001 no previeron la tendencia de la integración de circuitos y consecuentemente la obtención de máquinas cada vez más potentes pero cada vez más pequeñas. También fallaron al no predecir el cómputo distribuido, esto es, usar una red de computadores en vez de uno masivo. HAL fue inspirado claramente en los “grandes” computadores de los 60´s.

Además en los sesenta se falló al no entender la naturaleza importante y extraordinaria del software: que es de propósito general, infinitamente maleable, y se puede divorciar del hardware. Esta falta de la comprensión ayuda a explicar el número excesivo de los botones de control que vemos en la película, especialmente en las cápsulas. Una buena pantalla con software de ventanas y botones habría sido suficiente para ello.

Generalidades

Ahora, en el 2001, quizás nos preguntemos por qué no hemos conseguido el sueño de hacer un HAL. Las razones son ilustrativas. Desde un punto de vista general, en dominios concretos vinculados a problemas restringidos del habla, la visión, la planificación, el ajedrez.., son realizables si pueden ser completamente especificados. Pero en dominios tales como la comprensión de idiomas y el sentido común, que son problemas básicamente ilimitados en sus posibilidades y duros de especificar, estamos muy lejos.

Pienso que una clave importante de la IA es la necesidad de simultanear varias representaciones del conocimiento, tanto que cuando el sistema no avance al usar una representación, pueda saltar a usar otra e intentarlo nuevamente.

Otra clave fundamental es el procesamiento del Conocimiento en IA.

Hay tres enfoques básicos en este procesamiento: Basados en casos, basados en reglas y conexionismo.

La idea central de sistemas basados en casos (CBR), es que el programa ha almacenado los problemas y las soluciones. Entonces, cuando surge un problema nuevo, el programa prueba a encontrar un problema semejante en su base de datos encontrando los aspectos análogos entre los problemas. Sobre esa base de semejanzas se establecen las respuestas.

En sistemas basados en reglas o expertos, el programador introduce el conocimiento de un especialista humano en forma de reglas. El problema aquí está en determinar que se han introducido todas las reglas necesarias para que el sistema opere en condiciones normales y contemple mecanismos de aprendizaje (esto es, incorporar y/o eliminar nuevas reglas).

Los sistemas conexionistas se basan en redes grandes de componentes sencillos inspirados en las neuronas biológicas.

Sobre la disponibilidad de infraestructuras para la IA, la ley de Moore aporta un evaluación realista. Tenemos ya sistemas que pueden combinar el habla continua, vocabularios muy grandes, y la independencia de orador con la única limitación de la restricción del dominio. Pero estos sistemas requieren altas velocidades y memorias de procesamiento para ser viables desde el punto de vista del tiempo real. Aunque el poder de cálculo es crítico en el reconocimiento del habla y la comprensión, el problema central no está en la disponibilidad de computadoras de prestaciones suficientes para este procesamiento en un futuro cercano.

La ley de Moore expresa que las velocidades de computo y las densidades de almacenamiento se duplican cada dieciocho meses. Las transformaciones tecnológicas cada vez mayores, ocurren en unos pocos años.

De forma apreciable, esta ley ha tenido validez desde el comienzo del siglo XX. Comenzó con la tecnología basada en tarjeta mecánica usada en 1890 para el censo, cambió a las computadoras basadas en la válvula electrónica de los cincuenta, a las máquinas basadas en transistores de los sesenta, y a todas las generaciones de circuitos integrados que hemos usado en las últimas tres décadas. Si trazamos las capacidades de cómputo y memoria de cada computadora desarrollada en los últimos cincuenta años, obtenemos aproximadamente una línea exponencial de base 2, representando las prestaciones en función del tiempo para una cierta unidad de coste. Por ejemplo, hoy la memoria de las computadoras, es cerca de dieciséis mil veces más capaz, que la disponible en 1976, para el mismo coste unitario.

“LA EVOLUCIÓN DE LA INTELIGENCIA ARTIFICIAL NOS HA LLEVADO DESDE LOS PROMETEDORES AÑOS SESENTA, EN LOS QUE SE ESPERABA LLEGAR A LA CREACIÓN DE UNA MÁQUINA INTELIGENTE, HASTA LA SITUACIÓN ACTUAL, MUCHO MÁS REALISTA”

La ley de Moore nos proporciona la infraestructura para, en términos de la memoria, velocidad de cómputo y de la tecnología de comunicación, materializar avances en IA utilizando plataformas económicas. Pero no preve una cuestión central: el salto cualitativo de procesar información a procesar conocimiento y esto es fundamental en la IA.

Perspectivas actuales de la Inteligencia Artificial

A pesar de los avances conseguidos en los escasos 50 años de vida de esta disciplina, los problemas clásicos (percepción, lenguaje natural, juegos, demostración, etc.) siguen siendo objeto de investigación y el desarrollo de una teoría unificada de la inteligencia queda aún lejos. El desarrollo tecnológico, la profundización en el estudio de la representación y procesamiento del conocimiento y el progreso en campos afines (neurofisiología, sicología, biología) tendrán mucho que decir en el futuro próximo.

La evolución de la IA nos ha llevado desde los prometedores años sesenta, en los que se esperaba llegar a la creación de una máquina inteligente, hasta la situación actual, mucho más realista, en la que los avances tecnológicos se centran en dotar a las máquinas de componentes con ciertas conductas que podríamos denominar como “inteligentes”. En este sentido, y a modo de ilustración voy a mencionar cinco grandes grupos:

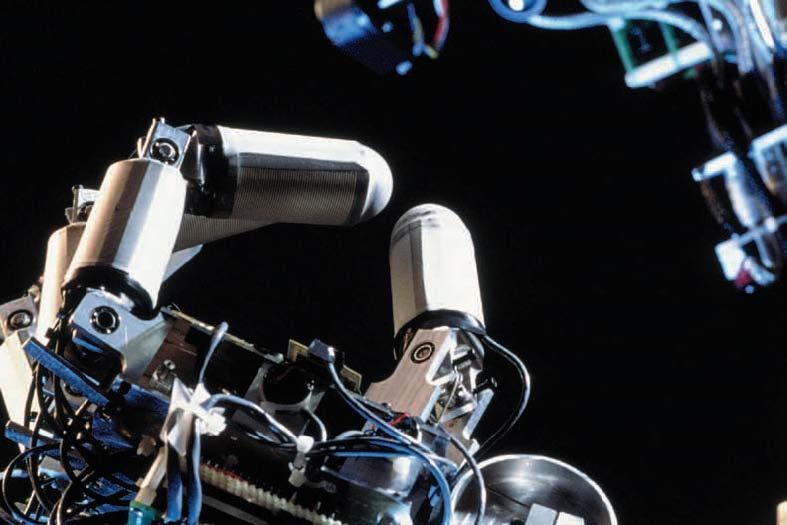

Las aplicaciones en el mundo industrial, fundamentalmente apoyadas en el desarrollo de la robótica.

Podemos hablar de cuatro generaciones de robots:

El sistema de control usado en la primera generación de robots esta basado en las “paradas fijas” mecánicamente. Este tipo de control es muy similar al ciclo de control que tienen aparatos de ciclo fijo. Son útiles para las aplicaciones industriales de tomar y colocar pero están limitados a un pequeño número de movimientos.

La segunda generación utiliza una estructura de control de ciclo abierto, pero en lugar de utilizar interruptores y botones mecánicos utiliza una secuencia numérica de control de movimientos almacenados en un disco o cinta magnética. Es frecuente el uso de estos robots en la industria automotriz, en soldadura, pintado con “spray”. Este tipo de robots constituyen la clase más usada actualmente en robots industriales.

La tercera generación de robots utiliza las computadoras para su estrategia de control y tiene algún conocimiento del ambiente local a través del uso de sensores, los cuales miden el ambiente y modifican su estrategia de control, con esta generación se inicia la era de los robots inteligentes que progresivamente, están sustituyendo a los de segunda generación, ampliando sus usos a control, planificación y calidad de procesos industriales.

La cuarta generación de robots, inteligentes con más y mejores extensiones sensoriales, para comprender sus acciones y el mundo que los rodea. Incorpora un concepto de “modelo del mundo”, de su propia conducta y del ambiente en el que operan. Utilizan conocimiento difuso y procesamiento dirigido por expectativas que mejoran el desempeño del sistema de manera que la tarea de los sensores se extiende a la supervisión del ambiente global, registrando los efectos de sus acciones en un modelo del mundo y auxiliar en la determinación de tareas y metas. En este marco se inscriben los robots autónomos, actualmente en fase de investigación e incipiente implantación industrial.

Las aplicaciones en el mundo de la ofimática que podríamos calificar de “inteligentes” puesto que realizan tareas propias del ser humano, entre ellas:

Los traductores, que son aplicaciones capaces de traducir textos escritos en lenguaje natural de un idioma a otro (a). La ambigüedad del lenguaje natural hace posible que podamos calificar a esta capacidad como “inteligente”. Estos sistemas presentan limitaciones vinculadas a giros sintácticos y semánticos.

Los sistemas de reconocimiento de caracteres tipográficos (OCR) o manuscritos (OCX) se basan en algoritmos de aprendizaje. Estos sistemas son capaces de extraer las características invariantes de cada letra para hacer efectivo el reconocimiento (b).

En los sistemas de dictado automático, el reconocimiento es a nivel de palabra. También se basan en modelos de aprendizaje, pero esta vez combinados con técnicas de análisis frecuencial (c). Debido a la diversidad de registros de voz, en estos sistemas es necesario realizar un aprendizaje específico para cada usuario.

Los agentes inteligentes diseñados para ayudar en línea al usuario ante determinadas situaciones. Por ejemplo, en ciertos paquetes de software, existe un asistente que inspecciona el trabajo que se está realizando. Cuando detecta, por ejemplo, que se está empezando a escribir una carta, nos ofrece una ayuda en línea para escribir una carta de propósito general.

“A PESAR DE LOS AVANCES CONSEGUIDOS EN LOS ESCASOS 50 AÑOS DE VIDA DE ESTA DISCIPLINA, LOS PROBLEMAS CLÁSICOS (PERCEPCIÓN, LENGUAJE NATURAL, DEMOSTRACIÓN, ETC.) SIGUEN SIENDO OBJETO DE NVESTIGACIÓN”

Otro grupo son las aplicaciones inteligentes de uso doméstico. Podemos citar varios ejemplos:

DC06 es un robot de limpieza de suelos (d). Está continuamente limpiando el suelo de una habitación a otra de la casa. El sistema de guiado se realiza mediante sónar y sigue estrategias de navegación específicas para cubrir toda la superficie posible esquivando todo tipo de objetos en el menor tiempo.

Los sistemas de control inteligente de electrodomésticos. Realizan múltiples funciones como el control energético de los mismos, autodiagnóstico en caso de fallo, reacción ante de cortes de luz, etc… (f).

Existen muchas aplicaciones de la IA a la medicina. Entre ellas:

Sistemas expertos capaces de realizar pronósticos de los efectos de la insulina. Estos sistemas resultan muy útiles para tratar distintas enfermedades tales como la diabetes (g).

Sistemas expertos basados en reglas capaces de diagnosticar un conjunto de enfermedades comunes a partir de un cuestionario que se realiza al paciente (h).

El Ojo de Dobelle (i), es un sistema que permite a los ciegos una cierta visión. El sistema se compone de una mini cámara de televisión conectada al córtex visual mediante unos electrodos. La imagen es procesada mediante técnicas de visión artificial y “traducida” al córtex visual.

Otro tipo son las aplicaciones conversacionales, cuyo propósito es el de sostener una conversación coherente con un ser humano (similar a la prueba de Turing). Los primeros sistemas se basaban en un sencillo sistema de reglas que disparaba una respuesta a partir del análisis de cada pregunta del usuario, dependiendo de la aparición en ésta de distintas palabras que consideraba claves. Los sistemas que han ido apareciendo con posterioridad son más sofisticados pero están basados en la misma filosofía:

Agentes inteligentes con los que se puede entablar una conversación. El sistema de reglas es incremental, o sea, es capaz de extraer de una conversación específica determinadas reglas e incorporarlas a la base de datos con lo que el sistema es cada vez más realista. Además, el sistema se conecta de forma automática a distintos centros de información (periódicos, revistas…) a través de Internet. Incluso se pueden conectar a canales de conversación en Internet y en muchas ocasiones pasar desapercibidos por otros usuarios de los canales (j). Estos agentes pueden dotarse de sistemas de respuestas con cierta “personalidad propia” (Por ejemplo simulando como contestaría John Lennon) (k).

Como se ha visto existe una gran variedad de ambientes, aplicaciones y contextos donde de forma muy concreta se usan elementos de la IA, que se están introduciendo progresivamente en nuestra vida cotidiana. Desde luego no se ha conseguido un Hal, pero es indudable que nos encontramos en pleno auge de los sistemas basados en componentes inteligentes.

[Quiero finalizar agradeciendo a Técnica Industrial la oportunidad que me ha ofrecido para colaborar en este número especial, sinceramente gracias.]

Referencias de las aplicaciones

- (a)

- Por ejemplo, el traductor automático en línea InterTran, creado por Translation Experts Ltd. es capaz de traducir entre 28 lenguajes distintos (http://www.tranexp.com:2000/InterTran).

- (b)

- Un buen ejemplo de aplicación de este tipo es el OCHREE (Optical Caracter Recognition) creado por Jason Tiscione (http://www.geocities.com/SiliconValley/2548/ochre. html), cuyo modelo de aprendizaje es el de redes neuronales artificiales (RNA).

- (c)

- Un buen ejemplo de este tipo de sistemas es el Dragon Naturally Speaking, creado por Dragon (http://www.dragonsys.com/international/sp/pdf/sp_s tandard4.pdf).

- (d)

- Creado por Dyson (http://dc06.dyson.com/motor.htm).

- (f)

- Maj@or Dom@, creado por Fagor (http://www.expocasa.es/domotica/index_marca.cfm ?p=016) es un sistema de control de los sistemas eléctricos del hogar. Realiza múltiples funciones: Nos avisa a nuestro teléfono móvil en caso de situaciones anómalas (detección de fuego o intrusos) y realiza tareas de control de gasto energético (iluminación, agua…).

- (g)

- Glucosa Controls, creado por Ramón Torra (http://www.glucosacontrols.org/).

- (h)

- MYCINE, creado en el Laboratorio de Nutrición Aplicada de la Universidad Complutense de Madrid (http://147.96.33.165/Interactivas/Mycine/base0.asp)

- (i)

- Creado en el Dobelle Institute de Nueva York (http://profesional.medicinatv.com/reportajes/vision/)

- (j)

- Zebal, (http://personal.readysoft.es/coding/zebal/). Se trata de un agente inteligente con el que se puede entablar una conversación. Su desarrollo hace que en ocasiones parezca que estemos hablando con un ser humano real. A diferencia de sus antecesores, que discriminaban palabras aisladas para disparar las reglas (nivel léxico), este sistema posee un motor de reglas basado en un compilador. Por tanto, el análisis de la frase es gramatical, y mucho más realista.

- (k)

- JLAIP (John Lennon Artificial Inteligence Project), creado por Apple Corps Ltd. (http://www.triumphpc.com/johnlennon/index.shtml) es un sistema similar al anterior, con la diferencia de que en este caso no se ha modelado un sistema de respuestas general sino uno con las características del cantante John Lennon. Esta dotación de personalidad es un importante avance en estos sistemas. Web de HAL´s Legacy: http://mitpress.mit.edu/ebooks/Hal/

Bibliografía

- J. Allen. Natural Language Processing. The Benjamin/Cummings Publishing Company, Inc., 1994.

- L. Bolc and J. Cytowski. Search Methods for Artificial Intelligence. Academic Press, 1992.

- B. Buckanan and E.H. Shortliffe. RuleBased Systems.The MYCIN Experiments of Stanford Heuristic Programming Project. AddisonWesley, 1985.

- C.L. Chang and R.C. Lee. Symbolic Logic and Mechanical Theorem Proving. Academic Press. NY, 1973.

- E. Charniak and D. McDermott. Introduction to Artificial Intelligence. AddisonWesley, 1985.

- A. G. Cohn and J.R. Thomas. Artificial Intelligence and its Applications. Pitman Pub, 1985.

- D. Crevier. The Tumultous History of the Seach for Artificial Intelligence. Basic Books (Harper Collins Publishers), 1993.

- H.L. Dreyfus. What Computers Still Can t Do? The MIT Press, 1992.

- R.O. Duda and P.E. Hart. Pattern Clasification and Scene Analysis. Wiley, 1973.

- J. Durkin. Expert Systems. Design and Development. PrenticeHall, 1994.

- D.M. Gabbay, C.L. Hankin, and T.S.E., editors. Algorithmic Learning. Maibaum, 1994. M.Boden, editor. The Philosophy of Artificial Intelligence. Oxford University Press, 1990.

- M. Minsky. Semantic Information Processing. The MIT Press, 1968.

- M. Minsky. The Society of Mind. Simon and Shuster, 1986.

- E. Rich and K. Knight. Inteligencia artificial. Segunda Edición. McGraw Hill, 1994.

- A.M. Turing. Computing Machinery and Intelligence. Mind, 1950.