La química se lanza al diseño por ordenador

La creación in silico de fármacos, materiales y otras moléculas se basa en la vasta capacidad de cálculo de las actuales supercomputadoras que permiten simulaciones de enorme complejidad

“La química ha dejado de ser una ciencia puramente experimental”. Con estas palabras celebraba la Academia de Ciencias sueca la concesión del premio Nobel de Química de 1998 a Walter Kohn y John A. Pople. En los años previos, ambos científicos habían realizado aportaciones fundamentales en el entonces reciente campo de la química teórica, una disciplina nacida del acercamiento de la física (especialmente la mecánica cuántica) y la química de laboratorio. Hoy en día, las aproximaciones teóricas a los problemas químicos son habituales y muchos químicos orgánicos tienen en cuenta los cálculos y predicciones de los químicos teóricos para decidir entre rutas de síntesis alternativas y determinar estructuras moleculares.

Para ello, la ciencia se ha apoyado en la vasta capacidad de cálculo de los actuales superordenadores, que han hecho posible cálculos y simulaciones de una complejidad inabordable. El resultado es la emergencia de una nueva ciencia denominada química computacional en la que los experimentos se realizan in silico, en clara oposición al trabajo in vitro habitual de un laboratorio al uso. Esta posibilidad se apoya en el drástico incremento de las capacidades de computación y la eficacia de los nuevos algoritmos.

“En la actualidad los investigadores en química computacional de todo el mundo utilizan arquitecturas de hardware paralelas de teraflops (1012 flops, un billón de operaciones por segundo) y petaflops (1015 flops, mil billones de operaciones por segundo) del rango de decenas a cientos de miles de procesadores para realizar sus simulaciones”, explica Roland Lindh, investigador del departamento de Química Cuántica de la Universidad de Uppsala, en Suecia. Estas simulaciones permiten resolver cuestiones hasta ahora inabordables, como el plegamiento de cadenas de aminoácidos para formar proteínas funcionales. Dado que un defecto en el plegamiento de una proteína está detrás de enfermedades como el Alzheimer, resulta de gran interés conocer las leyes que gobiernan la disposición de aminoácidos. Y esto no es una tarea sencilla.

Debido a que dos aminoácidos vecinos pueden enlazarse en tres ángulos diferentes, una proteína de 100 aminoácidos puede plegarse en 3200 formas diferentes. Los modelos informáticos para predecir estructuras proteicas se diseñan según dos metodologías básicas. Los modelos ab initio, en primer lugar, empiezan especificando las fuerzas de atracción y repulsión en cada punto y, a partir de ahí, calculan estructuras hasta encontrar el estado de menos energía. La modelización por homología, en cambio, hace sus predicciones comparando la proteína estudiada con proteínas con secuencias estrechamente relacionadas cuyas estructuras ya se conocen. La precisión de las predicciones depende de la resolución del modelo y de su capacidad para muestrear con mayor o menor profundidad el mapa energético para encontrar la configuración menos energética. Como resultado, los modeladores se enfrentan a una disyuntiva: si aumentan la resolución y mapean todos los átomos, limitan la cantidad de muestreos que un ordenador puede realizar. En cambio, si aumentan la frecuencia de muestreo, limitan la resolución. Para simplificar los cálculos, algunos investigadores refuerzan sus modelos informáticos con datos experimentales que limitan la búsqueda de la configuración menos energética de la proteína.

“La precisión de los resultados de los tratamientos teóricos depende, para simplificar, de la complejidad del propio problema y del método de cálculo empleado. Hay problemas que, por su naturaleza, no pueden ser tratados en el momento actual mediante métodos muy precisos y puede que la situación siga sin mejorar apreciablemente en el futuro”, comenta Ramón Carbó-Dorca, catedrático del Instituto de Química Computacional de la Universidad de Girona. “Pero hay problemas en los que la precisión de los resultados computacionales es comparable a los resultados experimentales”, añade.

Con esta opinión coincide Vicent Moliner, catedrático del departamento de Química Física de la Universidad Jaume I de Castellón, para quien las herramientas teóricas son capaces de proporcionar una enorme cantidad de conocimientos detallados que no siempre se consiguen con las técnicas experimentales, ofreciendo así métodos alternativos para analizar y entender los procesos químicos en estudio. “Las estrategias teóricas pueden verse como un experimento numérico que ayuda a los experimentalistas en el rediseño del sitio activo por medio de unas pocas mutaciones”, explica Vicente Moliner, cuyo grupo de investigación se ha especializado en el empleo de los computadores de altas prestaciones para el diseño teórico de mejores catalizadores e inhibidores. El resultado de su trabajo, y el de otros químicos computacionales, son propuestas que han de servir de instrucciones para sintetizar fármacos más eficaces o materiales con unas determinadas propiedades.

“Las técnicas computacionales pueden proporcionar una cantidad enorme de información sobre las reacciones químicas en medios complejos, ofreciendo pistas para el desarrollo de nuevos y más eficientes catalizadores biológicos”, explica Moliner.

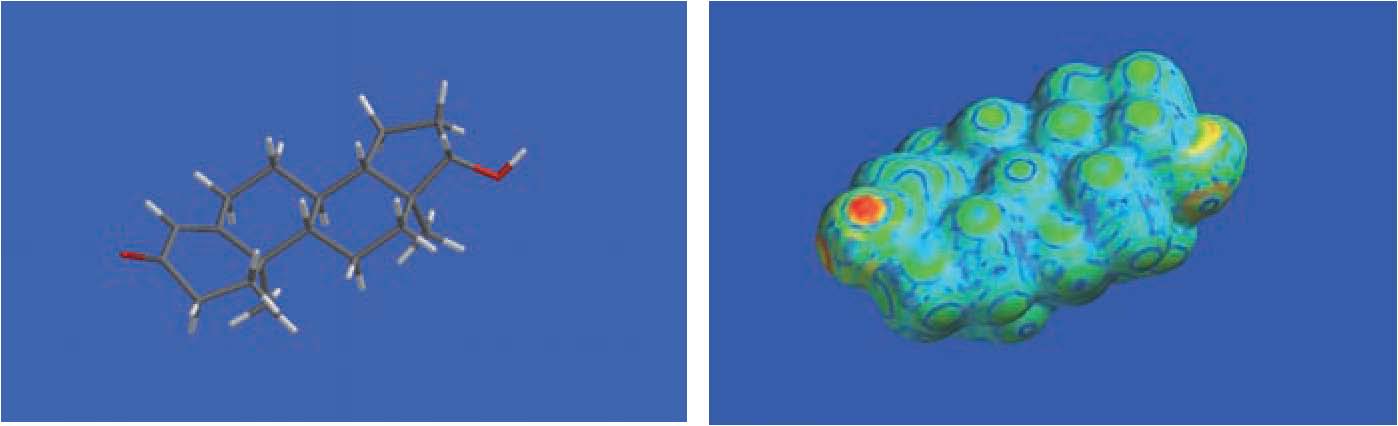

Toda reacción química atraviesa una suerte de limbo, un estadio fantasma entre los reactivos iniciales y el producto final en el cual es casi imposible conocer de manera experimental lo que ha ocurrido en el intermedio. Los científicos utilizan técnicas basadas en la química computacional para modelar de manera teórica ese estado de transición desconocido y diseñar de manera racional compuestos que inhiban o mejoren la acción de los catalizadores biológicos.

Diversidad de aplicaciones

Pero no terminan ahí las aplicaciones de la química computacional. “Desde el estado sólido, los agregados atómicos, las grandes macromoléculas, las moléculas de interés farmacéutico y las nanoestructuras, pasando por la catálisis, la reactividad química, la solvatación, las interacciones moleculares en general, el llamado docking de substratos de proteínas, todos estos problemas en mayor o menor medida constituyen estudios habituales en química computacional”, dice Carbó-Dorca, uno de los pioneros de la química computacional en nuestro país. “De entre todos ellos emergen las llamadas relaciones estructura-propiedades cuantitativas [QSPR, en sus siglas en inglés], que ahora forman parte de los elementos básicos con que cuentan los químicos para diseñar nuevas estructuras con propiedades bien definidas”.

El enorme desarrollo de la potencia de cálculo, así como la puesta a punto de algoritmos matemáticos mucho más efectivos ha permitido a la química teórica y computacional pasar del estudio de pequeños sistemas aislados en fase gas a explorar y caracterizar las propiedades de grandes sistemas, incluyendo en las simulaciones el efecto del medio. La conjunción de los métodos teóricos con datos obtenidos por técnicas experimentales tales como la difracción de rayos X, la resonancia magnética nuclear, las técnicas de mutagénesis dirigida, los estudios de efectos isotópicos cinéticos, la ingeniería molecular y las recientes espectroscopias de femtosegundo y atosegundo abre un abanico de posibilidades al proporcionar una herramienta interdisciplinar muy prometedora.

Sin embargo, también tienen limitaciones, pues la capacidad de procesamiento de datos de los centros de cálculo más potentes tiene sus límites. “Las limitaciones vienen impuestas por el hardware disponible y su capacidad de tratamiento de estructuras químicas de gran tamaño o grandes enjambres de moléculas pequeñas”, explica Carbó-Dorca. Y, aunque sus prestaciones vayan a aumentar en el futuro gracias al avance de la computación paralela, la tecnología actual tiene unos límites físicos que no se podrán superar, como ponía en evidencia en una entrevista en estas mismas páginas el premio Nacional de Investigación José Duato, quien participó en el diseño del supercomputador que durante cuatro años fue el más potente del mundo, el BlueGene/L de IBM, con 64.000 procesadores. El BlueGene/L fue diseñado para estudiar el plegamiento de los aminoácidos de una proteína, precisamente.

“Siempre habrá un horizonte que una máquina construida con los principios al uso no podrá superar. Otra cosa será si se construyen máquinas de calcular cuyos principios sean completamente distintos de los actuales. Quizá los llamados ordenadores cuánticos sean la respuesta”, apunta Ramón Carbó-Dorca.