El laberinto nanotecnológico

Antes de entrar a contestar estas preguntas sería conveniente decir que la ciencia de la nanoescala y la tecnología que desarrolla, se encarga de estudiar sistemas en el rango del nanómetro (un nanómetro es la mil millonésima parte de un metro, 1nm=0.000000001 metros), como ejemplo diremos que un átomo tiene un tamaño aproximado de 0.2nm y claro, en consecuencia, que este arte trata con átomos y moléculas individuales, uno a uno. No de manera estadística como ha venido haciéndose hasta hora. Esto permite modificar un sistema para poder obtener propiedades físicas, químicas, biológicas…, deseadas o al menos éstas son las pretensiones.

Es un espacio/tiempo de imaginación donde los filósofos y los artistas plásticos también tienen mucho que decir.

La nanoescala

La pregunta que deberíamos hacernos es por qué aparece o se impone la necesidad de la moda de la nanoscala? –todo nuevo campo de desarrollo en la ciencia, a mi modo de ver, no es más que una moda–. La razón hay que buscarla en las necesidades que se va planteando el sistema productivo y en la aportación creativa que es función del desarrollo y la educación/conocimiento de las sociedades. No sabemos cuándo una nueva ciencia va a surgir pero cuando aparece es porque la cosa está madura para que así sea y entonces las necesidades de la misma son evidentes.

El Renacimiento creó en nuestra sociedad la ansiedad de conocimiento por las cosas que nos rodeaban y abrió las puertas a un campo de ciencia como respuesta a muchas preguntas que se nos habían presentado y que se trataron de contestar por medios básicamente teológicos. Recordemos a Galileo. Se volvía a la creatividad y la observación clásicas. Aunque no debe entenderse que la ciencia es la panacea de todo, negarla es una necedad.

Cuando Faraday descubrió a principios del siglo XIX la Ley de inducción magnética por la que una variación de flujo magnético produce una fuerza electromotriz, sólo descubrió que circulaba una corriente pequeña por un hilo cuando se movía un imán. Pero ahora sabemos que sin este descubrimiento no se hubiera desarrollado toda la técnica industrial moderna de los motores eléctricos y la transformación de todo tipo de energía en energía eléctrica. Se puede decir que un paisaje sin tendidos eléctricos es sinónimo de subdesarrollo con todo lo que esto conlleva.

Otro gran descubrimiento: el descubrimiento del siglo XX es el transistor. Hecho en 1948 por Bardeen, Brattain y Shockley, este descubrimiento científico ha cambiado la vida del siglo XX. Cuando observaron el efecto no tenían ni la menor idea, ni podían vislumbrar, de sus repercusiones. Toda la electrónica actual está basada en el transistor más o menos compactado con las técnicas microelectrónicas.

El transistor ha abierto el espacio a los humanos y nos ha hecho tener una vida más larga, llevadera y nos ha insertado en un mundo de comunicaciones. El transistor es el paradigma más claro de cómo la ciencia y la tecnología van abrazadas.

Un ejemplo interesante que combina la tecnología desde El Renacimiento a nuestros días. La cartografía y la distancia. A principios del siglo XV la cartografía era la llave para la ampliación del mundo. El descubrimiento de América por Colón y la vuelta al mundo por Magallanes abrió tremendos horizontes nuevos. En aquella época, como dice la filosofa Hannah Arendt en su libro La Condición Humana, “la distancia regulaba nuestros movimientos”.

Las nuevas técnicas de navegación y realización de mapas hacían más ancho nuestro globo. Sin embargo, actualmente la ciencia tiende a reducir las distancias, a compactar. En su mismo libro, Arendt dice: “la reducción del espacio y la abolición de la distancia por los ferrocarriles, barcos a vapor y aeroplanos”. Esto hasta el punto que Frances Cairncross, en su libro La Muerte de la Distancia, afirma algo así como que los bordes geográficos, las zonas horarias, etc., empiezan a ser irrelevantes debido a la revolución de las comunicaciones.

Algo bastante razonable debido a los teléfonos, televisión y medios, todos llevados por las tecnología de las computadoras. A todo ello ha contribuido el transistor y sin él la contracción del espacio y la virtualidad de los hechos no se podría haber dado. Bueno, el transistor y la compactación de los chips para en menos espacios introducir más información: los chips super integrados.

Aquí hay un hecho nuevo, la integración, la miniaturización a través de las técnicas microelectrónicas. ¿Se imaginan ustedes un satélite espacial hecho de las antiguas válvulas?, ¿cuánto pesaría?, ¿cómo debería ser de grande?. Imposible de poner en órbita. La electrónica es el soporte de toda la tecnología moderna.

Los países que se lanzaron a la aventura de la integración de transistores, a la microelectrónica, con ventaja inicial son aquellos que han marcado las pautas con una diferencia abismal sobre los otros. Y, naturalmente, todo se ha hecho con tremendos beneficios de aquellas empresas que se pusieron a la tarea.

Los beneficios empresariales son propulsores del desarrollo de nuevas ciencias y tecnologías. Otro punto importante.

Anular distancia y tiempo

Pero no sólo se quiere anular la distancia sino también el tiempo. Queremos los hechos sin dilación y no importa en qué punto, no ya de La Tierra sino del Universo, en definitiva un mapa espacio/tiempo del Universo. La sociedad multiplica diariamente su grado de complejidad y, en consecuencia, de caos y su funcionamiento requiere localidad y temporalidad reducidas a una virtualidad cotidiana.

Ya no sirven noticias con horas de retraso, se sucedan los hechos en el lugar que sea. Esto requiere sistemas inteligentes merodeando por todo el espacio. Necesitamos trasmisores rápidos audio visuales de fácil acceso y sistemas de recepción multidimensionales de fácil utilización y personalizados a la información que quiera tener cada individuo. No podemos andar con el ratón, el buscador, el computador de mesa… La recepción debe ser instantánea, personalizada y ejecutada por órdenes sonoras. Debemos llevar integrados sistemas de información audiovisuales y multilingües. Necesitamos nanorobots inteligentes que hagan toda la tarea de selección e información. Esto no se puede hacer con las técnicas de microelectrónica que integra chips en la región del micrómetro facilitando Gigabits por centímetro cuadrado (1,000,000,000 bits por centímetro cuadrado).

Aquí aparece una necesidad tecnológica nueva: integración en el nanómetro. Esto facilitaría integraciones de Terabits (un billón de bits por centímetro cuadrado), mil veces el Gigabit. La memoria de cien ordenadores de mesa integrados en una moneda. Memoria suficiente para poder tomar decisiones y almacenar una cantidad de datos que en un momento determinado puede ayudar a un buen software a tomar decisiones airosas en una situación complicada. Esto es inteligencia.

Es difícil definir la nanotecnología, pero sus fines son conseguir sistemas o robots por billones y pequeños con capacidad de decisión, inteligentes, que actúen como complemento integrado del hombre/mujer (por igual) en una sociedad cada vez mas compleja, caótica y dinámica. Lo cual no quiere decir una sociedad mejor ni más libre.

La última decisión la tienen los ingenieros

Para realizar lo anterior, los científicos y, sobretodo los ingenieros, necesitan los medios y las técnicas que lo hagan posible. Es necesario el conocimiento básico pero la última decisión sobre lo qué es posible o no en el momento actual como dispositivo útil, versátil y seguro la tienen los ingenieros que desarrollan las ideas básicas.

Las técnicas que han facilitado y de las que disponemos para realizar la tarea son especialmente microscopios que nos acercan a la materia en sus detalles mas pequeños. Como en cartografía, no se puede hacer un viaje si no se sabe a dónde. Aquí no podemos realizar o modificar un objeto con una característica si no tenemos un conocimiento profundo de lo que partimos. Por eso el microscopio óptico nos abre el campo celular y de unos pocos micrones y el microscopio electrónico nos introduce en el campo submicroscópico (debajo de la micra). Estos dos aparatos son quizás las herramientas mas revolucionarias de los últimos 50 años. Ya podemos conocer la materia en limites increíbles anteriormente. Y lo que vemos es que los sistemas a tratar no son regulares y están llenos de defectos y es curioso que son casi siempre los defectos los que dominan las propiedades físicas y químicas.

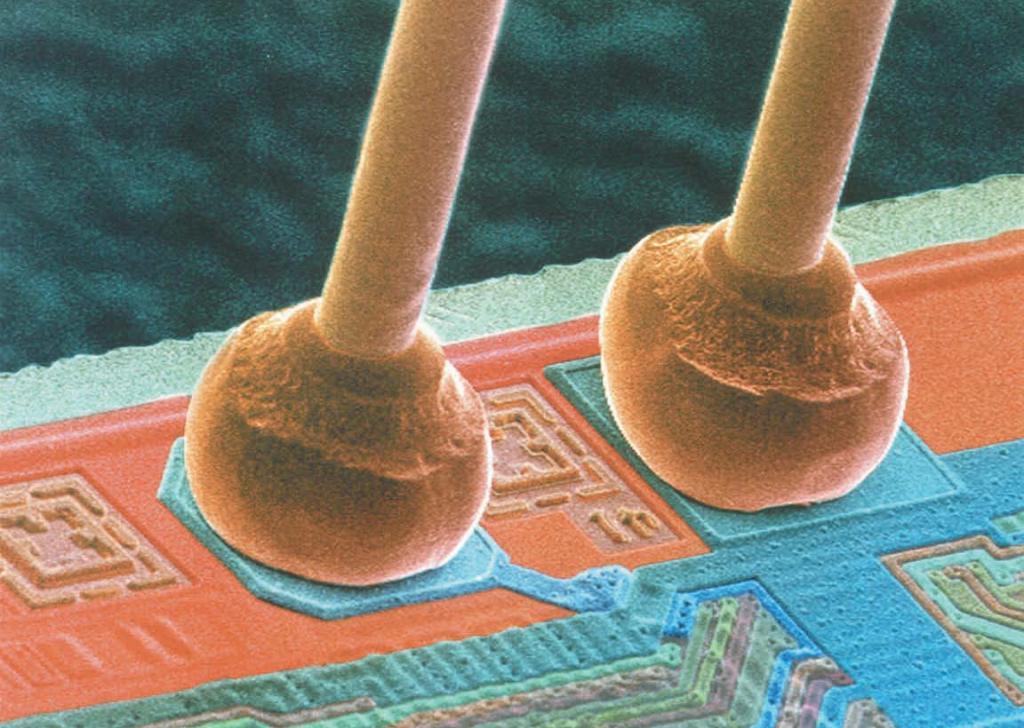

La industria ha hecho, desde hace mucho tiempo, de estas dos herramientas parte de su paisaje y son necesarias en cualquier laboratorio, sea industrial o de investigación, que se precie de avanzar tecnológicamente. También aparece el microscopio de efecto túnel y sus adláteres (pruebas locales) a partir de los ochenta. Esta nueva técnica tiene una nueva característica que es interesante diferenciar. Mientras que en los microscopios óptico y electrónico las sondas que se envían (luz/fotones y electrones) provienen de distancias relativamente lejanas al objeto que se quiere observar, el microscopio de efecto túnel es básicamente un palpador, más que vista tiene un buen tacto.

La diferencia es como leer con gafas o con el método Braille, de esta manera, aunque estemos ciegos, podemos sentir y este sentimiento por medios electrónicos podemos transformarlo en una imagen. Pero con una posibilidad adicional, que ahora si nos place podemos modificar el objeto y al modificarlo quizás podamos cambiar sus características físicas y químicas. Además, si esto lo hacemos con una sensitividad de átomos, que son los ladrillos del mundo que nos rodea (nótese que la mayoría de las propiedades y dispositivos que utilizamos provienen de la estructura atómica y no nuclear, excepto la energía nuclear), nos podemos convertir en “albañiles/ingenieros atómicos” con todo lo que esto conlleva. Por ejemplo, una estructura química puede tener unas propiedades distintas con sólo cambiar un átomo en su superficie. Los catalizadores es lo que hacen.

Con esto en la mano y las técnicas y dispositivos electrónicos,ópticos, magnéticos, etc., sólo queda la imaginación. Y como se cita en el artículo de García y Rohrer sobre nanotecnología (www.fsp.csic.es): “Entonces vienen la imaginación y la curiosidad científica: si podemos ver y palpar átomos al mismo tiempo también los podemos manipular uno a uno, podemos escribir con ellos!. Lo que quería Feynman es posible, el punto de la i puede ser un átomo separado de tres átomos que forman el palo, con nueve átomos podemos escribir una letra. ¡Podríamos escribir todo lo que se publica en España en un año en una superficie de un centímetro cuadrado (en una peseta)!. ¿No les parece fantástico e impensable?. Pues ya se ha hecho.”

“Lo que ocurre es que escribir una letra con una punta cuesta días. No importa, integramos un millón de puntas en un chip de microelectrónica (proyecto milpies). Ya se ha hecho. Y podemos modificar superficies y hacer nanohilos y nanocontactos que permiten densidades de corriente 1 millón de veces más grandes que el más puro hilo de cobre, porque no son disipativos y su resistencia eléctrica es no local. Y estos contactos si son magnéticos tienen características magnetoresistivas enormes a temperatura ambiente. Y podemos medir las fuerzas de enlace atómicas. Y podemos agrupar átomos con características funcionales deseadas. Y podemos estirar proteínas y DNA y ver cuál es la magnitud de las fuerzas que las mantienen unidas. Y podemos manejar nanotubos y otras moléculas y macromoléculas. Y podríamos…”.

Una ciencia y tecnología multidisciplinar

Sin embargo, todo este “podríamos” hay que concretarlo y lo primero que observamos es que no es una sola disciplina la que está envuelta en el proceso, además de que en el terreno del nanómetro aparecen nuevos efectos cuánticos que en muchos casos dominan completamente la escena. Estamos en el territorio físico, químico y, más complejo, biológico. Nótese que en la región del nanómetro una simple rotación de un enlace químico puede dar lugar a unas propiedades u otras y, posiblemente, esto pasa también en una codificación genética.

En esta región, los modelos de simulación matemática por ordenador son fundamentales, de esta manera se puede “aprender”, después de utilizar códigos complicados y días de cálculo de ordenadores potentes, cuál es el resultado de cambiar tal o cual átomo. Es muy complicado, extremadamente complicado para entenderlo. Nos encontramos con una ciencia/tecnología multidisciplinar donde físicos, matemáticos, químicos, bioquímicos e, incluso artistas plásticos, son necesarios. Es un terreno de nadie. En mi opinión, posiblemente un filosofo o un buen artista plástico pueda contribuir más que un buen científico especializado en una disciplina.

El concepto de generalidad empezando desde lo sencillo y simple es muy importante en lo que nos lleva. Y se necesitan excelentes ingenieros con gran imaginación. Gente que sea capaz de vislumbrar el desarrollo de una idea simple en un dispositivo que funcione con probabilidad muy cercana a la unidad. Lo mismo que necesitamos que el corazón no falle.

Veamos ahora algunos campos en los que la ciencia de la nanoescala podría influir rápidamente, en un plazo de 5 a 10 años aproximadamente.

El afán de prolongar la existencia

No es necesario explicar con detalle que desde el principio de la humanidad el hombre tiene conflictos con otros hombres y que esto ha conducido a guerras muy crueles (algo que se discute en el punto siguiente). Pero el gran conflicto del hombre es consigo mismo, en su perduración, su juventud y su vejez, en definitiva, su existencia (léase Bertrand Rusell en Nuevas esperanzas para un mundo en transformación). Éste es el objeto que discutimos en este punto concreto. La medicina es la que se encarga en general de la vida y el bienestar humano y también de los animales o, al menos debería hacerlo. La nanotecnología tiene mucho que decir aquí. Si miramos atrás, es cierto que la medicina y los fármacos han aumentado la calidad de vida media entre los humanos en 40 años en el último siglo y, seguramente, querrá seguir haciéndolo.

“NOS ENCONTRAMOS CON UNA CIENCIA/TECNOLOGÍA MULTIDISCIPLINAR DONDE FÍSICOS, MATEMÁTICOS, QUÍMICOS, BIOQUÍMICOS, E INCLUSO ARTISTAS PLÁSTICOS, SON NECESARIOS. ES UN TERRENO DE NADIE. EN MI OPINIÓN, POSIBLEMENTE UN FILÓSOFO O UN BUEN ARTISTA PLÁSTICO PUEDA CONTRIBUIR MÁS QUE UN BUEN CIENTÍFICO”

Pero veamos cuál ha sido su desarrollo. En mi opinión, éste ha estado dominado completamente por las tecnologías, por las técnicas de diagnóstico, reconocimiento y analíticas. El esfuerzo está en anticiparse a las enfermedades y aquí esta el secreto: se necesitan técnicas de detección muy precoz. Sin ellas no hay posibilidad de avance. Voy a decir algo que es heterodoxo y que mucha gente puede que no esté de acuerdo, pero es lo que pienso. Hoy en día se piensa que la geonómica va a solucionar problemas miles. Los medios nos bombardean con propaganda a tuti plen de lo que se hará con la manipulación genética, la clonación o mejor transplante nuclear y la capacidad para curar enfermedades. No soy de los que por razones éticas, morales o religiosas se oponga a estas técnicas, más bien todo lo contrario y los científicos harán lo que crean que deben de hacer, estoy seguro de ello. Pero lo del genoma y su panacea, que es extremadamente importante, huele bien y mal.

Hay mucha propaganda envuelta por una floreciente industria biotecnológica en donde el resultado en Bolsa, sobretodo, es lo que más cuenta. Conocer el genoma es conocer un código pero no se sabe como funciona el hardware que lo utiliza. No está claro que la modificación de un gen arregle una enfermedad sin efectos secundarios importantes. Cualquier científico que trabaje con software complicado sabe que la modificación de una parte pequeña del código puede generar variaciones importantes en muchos de los outputs que produce el código.

El futuro de la medicina esta en las técnicas de detección precoz. Antes de que una enfermedad se desarrolle, por ejemplo un cáncer, en su estado muy primitivo deben aparecer un conjunto de células que no deberían estar, que son ajenas al órgano donde se desarrollan y que crecen incontroladamente. Si tuviéramos capacidad de detectarlas cuando no son más que un número pequeño y tratarlas localmente, seguramente remediaríamos la enfermedad.

Es conocido que los cánceres de mama se han controlado enormemente gracias a las mamografías periódicas y eso que las técnicas existentes son muy groseras, detectan objetos de milímetros donde hay millones de células. Si tuviéramos nanorobots o chips inteligentes con una memoria como la descrita al principio de este artículo se podría dedicar a tener un diagnóstico de nuestro organismo y estaríamos bajo un control constante. Existe un proyecto NASA para construir un nanosubmarino (pequeño e inteligente que circule por las venas) que se pasee constantemente por el sistema circulatorio sanguíneo y nos informe de lo que observa.

Cuando encuentre una anomalía envía una información al ordenador integrado que portaremos y éste le da una orden para que descargue una cantidad ínfima de droga, picogramos (1 picogramo es una billonésima de gramo), o menos a la zona afectada. La droga se deposita localmente y no se necesita más. Ahora cuando se toma una medicina se afecta una zona amplia del cuerpo. Esto no debería ser necesario. El futuro que se vislumbra es que el ser humano vaya equipado con un ordenador pequeños pero de gran capacidad que se encargue de sus comunicaciones y relaciones exteriores y del control prácticamente instantáneo de su salud. Así es como puede extenderse la calidad y la vida de los hombres.

En definitiva, se trata de tener un mapa químico del individuo en tiempo real, incluso de los mecanismos que producen la consciencia. Esto es lo que ha venido ocurriendo a otra escala con la microcirugía, las técnicas láser, de diagnóstico, robots, etc. Y no parece que no vaya a seguir siendo. De hecho, las transformaciones genéticas que se quieran hacer tendrán que ser necesariamente complementarias e implementadas por estas nuevas técnicas de diagnóstico muy precoz y tratamiento local.

Los sistemas y estrategias militares

Aquí EEUU está gastando cantidades enormes de dinero en nanotecnología. Las nuevas guerras no se hacen tomando una decisión sin consultar simulaciones de ordenador que tienen en cuenta los distintos agentes de la contienda. Las nuevas guerras se basan en simulaciones que optimizan resultados con códigos complicadísimos y potentes ordenadores capaces de manejar un enorme número de datos y variables que deben ser obtenidos por la inteligencia. Lo cierto es que la tecnología actual no dispone de los medios necesarios para obtener datos verídicos que merezcan ser introducidos en la simulación de ordenador, ni para diseñar la estrategia óptima.

Por otra parte, a las agencias de inteligencia les faltan “actuators”. A pesar de su aparente sofistificación, los medios militares de los que dispone Occidente no son más que chatarra que no está a la altura de las exigencias de la opinión pública. Las armas actuales son mortíferas, destructivas y groseras. A pesar de los esfuerzos técnicos y de la propaganda informativa, los misiles no seleccionan, sus efectos colaterales no son pequeños, afectan a poblaciones inocentes y a bienes de producción, crean inestabilidad económica, y son siempre tardíos. En resumen; los medios existentes son a extinguir, no son inteligentes y no pueden actuar in situ de una manera limpia en respuesta a una información instantánea. Hay quien piensa que la guerra debe ser destructiva y con máximo daño para que el enemigo sepa a que atenerse si entra en guerra. Pero esto es solamente una manera de crear Pax Romana, y cualquier sociedad avanzada debería repudiarlo.

La guerra del futuro

Los MEMS, microelectronic mechanical systems (dispositivos mecánicos microelectrónicos), son dispositivos micrométricos inteligentes que podrán resolver los problemas descritos anteriormente y que las agencias de inteligencia e investigación de Occidente están intentando desarrollar, desde hace un par de años. El mérito de los MEMS será que podrán comunicar y actuar mecánicamente, bajo órdenes dadas, en el sitio e instantes deseados, de ahí su nombre de dispositivos mecánicos microelectrónicos.

La guerra del futuro se hará con estos dispositivos como armas limpias guiadas por optimizaciones de programas de ordenador cuyas soluciones se irán obteniendo por alimentación de datos obtenidos in situ. Los ordenadores darán órdenes de actuación a los mismos dispositivos que envían la información o a otros similares que tendrán capacidad de actuación y que estarán prácticamente en el mismo sitio que los informadores. Un ejemplo, supongamos que fuera posible construir un dispositivo que tuviera un tamaño de 10 micras de ancho, (una décima del grosor de un pelo) prácticamente invisible al ojo humano y que además tuviera una memoria de 10megabits (diez millones de bits).

Esta memoria sería suficiente para que el dispositivo pudiese trasmitir datos obtenidos en un sitio dado en una frecuencia determinada, así como recibir órdenes. Además permitiría, bajo una orden dada, hacer actuar una parte mecánica que inyectara una carga letal a un objeto o persona determinada. Imagínense un “mosquito” invisible con una carga mortal y un aparato receptor y emisor. Al mismo tiempo, imaginen que este “mosquito” no necesita energía para volar porque con su tamaño flota en el aire y cualquier corriente de aire o diferencia de temperatura lo mueve. Se preguntaran cómo se coloca este dispositivo en un sitio deseado.

La respuesta es que no se deposita un dispositivo, sino billones de ellos que a su vez se comunican entre si y se coordinan y toman decisiones. Estos dispositivos formarían un network en comunicación con superordenadores exteriores y se depositarían por medio de una inofensiva explosión de un proyectil en el sitio deseado. Pero, naturalmente, el peligro a nuestras libertades que impone el marco descrito anteriormente es muy grande. Por eso es necesario que las democracias elijan líderes inteligentes con profundos conocimientos y de gran capacidad de diálogo y tolerancia. La sociedad debe ser cada vez más libre, no puede dejarse controlar por no se sabe quién ni cómo.

Las comunicaciones y la computación

Donde la nanotecnología va tener mas influencia es en las comunicaciones y computación, debido en parte a que estos han sido los motores de su desarrollo, los que han planteado su necesidad por la competitividad existente y debido a que son el soporte de todo desarrollo. Desde el descubrimiento del transistor, cada vez más, las compañías de este campo han establecido una guerra sin cuartel para ver quién producía mas barato y con más capacidad. La microelectrónica se desarrolló igualmente por y para la miniaturización de las chips. Sin embargo, ahora se empieza a vislumbrar que la miniaturización y el silicio (los semiconductores) como base, puede que no den para mucho más y su fabricación cada vez es más complicada.

La alternativa es objetos con mucha más memoria y más capaces. Moléculas orgánicas que puedan transportar corriente eléctrica sin muchas perdidas permitirían hilos de conducción diminutos que son necesarios para la integración de cualquier chip. Utilización de la componente del espín del electrón para combinarlo con la corriente eléctrica, lo que se llama espintronics. De esto ya se han desarrollado chips que son operativos para memorias magnéticas y su integración puede multiplicarse muchísimo utilizando nanocontactos magnéticos.

Nuestro laboratorio es líder en la producción de nanocontactos magnéticos con propiedades al paso de corriente eléctrica con una gran señal como respuesta a un campo magnético. Memorias de materiales ferroeléctricos y optoelectrónicas todas ellas integradas en el nanómetro. En el laboratorio ya existen, el problema es hacerlas en serie, ”reliables” (que funcionen siempre) y no sean volátiles. Esta última propiedad no es ninguna tontería porque hasta ahora no se ha conseguido una alternativa para el papel cuando los documentos se quieren archivar por largo tiempo. Es cierto que tenemos memorias con gran capacidad y las queremos de todavía más pero no son válidas para lo que se llama archivo de documentos. Las memorias tecnológicas de archivo son muy volátiles.

El primer problema que se presenta es ¿cómo producir todo este volumen de chips?. Han de buscarse procedimientos similares a los que sigue la naturaleza, es decir que uno facilita una semilla con un código reproductivo y se producen billones con una estructura deseada. Algo así como hace el DNA pero con cadenas mucho más sencillas y de reproducción más rápida. Éste es el futuro lejano. Aquí la electroquímica a nivel nanométrico tiene mucho que decir. Nótese que los seres vivos son un gran vaso electroquímico diferenciado en distintos puntos. El cercano va a ser con técnicas híbridas entre semiconductores, moléculas orgánicas y metales como continuación de lo que ya existe, ya que la industria no puede cambiar sus cadenas de producción y sus inversiones rápidamente y se necesita un cambio de mentalidad managerial.

“EN ESPAÑA CADA VEZ QUE HAY UNA REFORMA UNIVERSITARIA LA ARMAMOS. NO VOY A DISCUTIR SI CON RAZÓN O NO, PERO JAMÁS LA HEMOS ARMADO POR UNA BUENA FORMACIÓN PROFESIONAL”

Las nuevas chips con mucha más memoria serán el futuro de las nuevas comunicaciones de banda ancha y tratamiento de datos. Cada persona portará como un apéndice un miniordenador para sus comunicaciones, y vivirá un mundo virtual con noticias y visualizaciones de lo que le interese y suceda. Este mini ordenador también será el que regule el diagnóstico médico que citábamos anteriormente. Nótese que a lo que se llama nuevas tecnologías en comunicaciones, las que ya existen, provienen de conocimientos existentes hace 20 años por lo menos y si miramos atrás vemos la “revolución” que se ha producido.

La nanotecnología tiene que se capaz de hacer lo que hacemos ahora pero con órdenes habladas en cualquier lengua, con comunicaciones audiovisuales al mismo tiempo que se va andando. Deber ser una parte cotidiana del ser humano, como llevar gafas pero con televisión en miles de canales e interactiva, por ejemplo.

Finalmente, dado el carácter de este artículo y puesto que se incluye en una publicación dedicada a la Ingeniería Técnica Industrial, quisiera resaltar que no sabemos cuál de las iniciativas que se están tomando abrirá un camino de desarrollo real –cada día se publican cientos de artículos científicos con resultados sobre el tema– pero, sin duda, habrá desarrollos y estos dependerán de la imaginación de los ingenieros que están en las líneas de producción que son los que saben los problemas y las necesidades reales.

Siempre han sido los ingenieros, los científicos pueden ayudar a hacer comprender por qué ocurre algo pero el “baby”, el dispositivo que utiliza “mamá”, es del ingeniero. Y no del ingeniero que dirige la empresa sino del que sabe qué producto es factible, sin ficciones. En España cada vez que hay una reforma universitaria la armamos, no voy a discutir si con razón o no, jamás la hemos armado por una buena formación profesional (los ingenieros técnicos).

Esta es la base de cualquier proyecto industrial y del desarrollo tecnológico. No estaría de más que tuviéramos muchos más ingenieros técnicos. Ello sería el paradigma de que nuestro país puede ser un país líder en el desarrollo tecnológico. Tras lo expuesto, es claro que hay mucho lugar para soñar y realizar desde la ciencia básica el desarrollo de un producto. En fin, la ciencia/tecnología de la mano, como siempre ha sido y será.