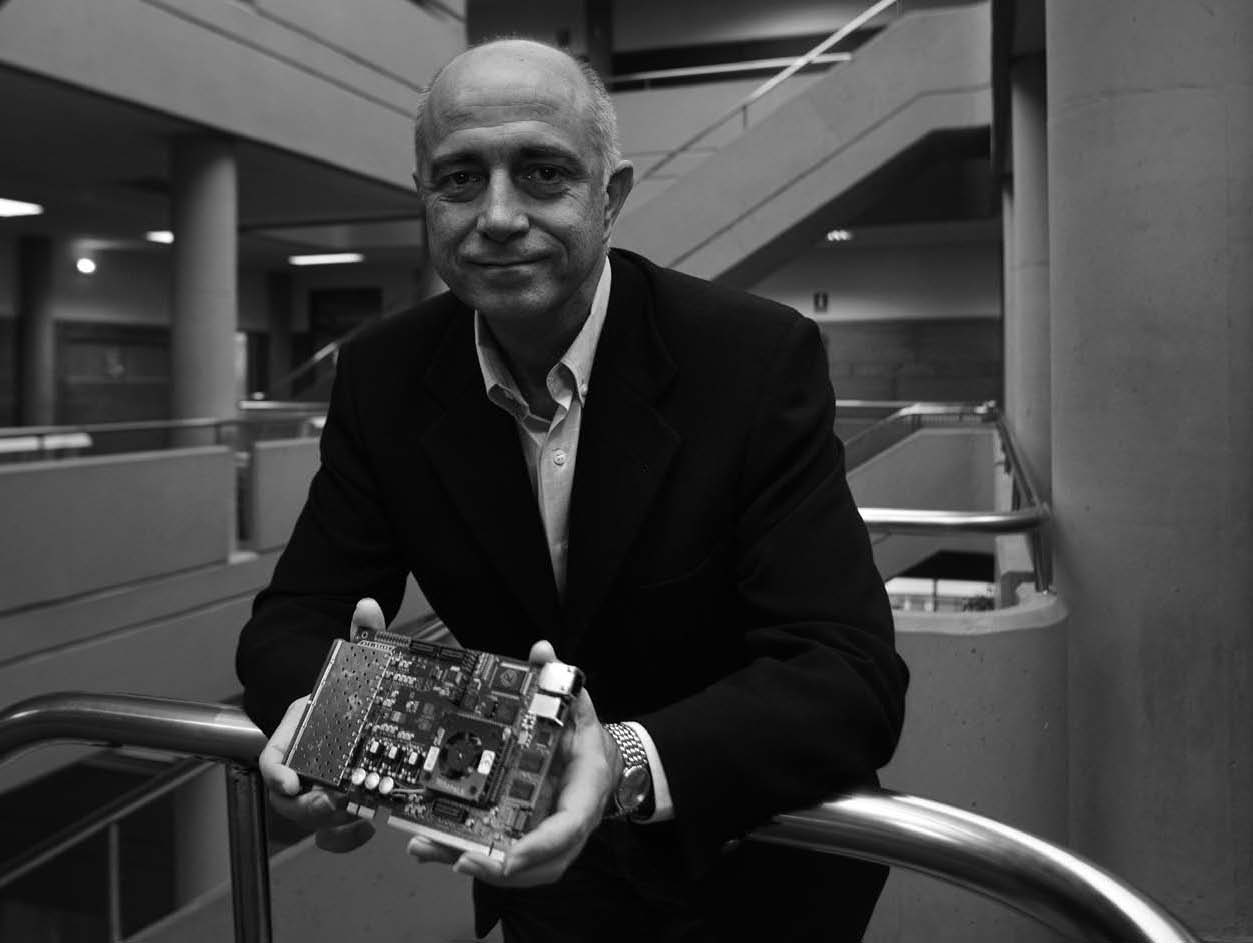

José Duato Marín

“LOS SUPERCOMPUTADORES NOS PERMITIRÁN MODELAR LAS REALIDADES FÍSICA Y QUÍMICA Y HACER ANÁLISIS MUCHO MÁS SOFISTICADOS”

En algunos momentos de la entrevista, José Duato Marín (Alberic, Valencia, 1958) deja que su mirada se pierda en un cubo de metacrilato que hay sobre la mesa y que aloja en su interior un diminuto chip. Recuerda a un paleontólogo que contempla embelesado un insecto prehistórico atrapado hace millones de años en una pieza de ámbar. En este caso, el peculiar insecto de silicio contiene 64.000 procesadores que lo convirtieron durante un tiempo en el supercomputador más potente del mundo: el BlueGene/L de IBM. Duato, catedrático de la Universidad Politécnica de Valencia, es el autor de una teoría que hace posible que esos 64.000 procesadores intercambien datos de forma eficiente, aumentando así la capacidad de cálculo del dispositivo. Por esta, y por otras aportaciones que han aumentado la potencia de los servidores de Internet, este experto en redes de comunicación y supercomputación recibió en 2009 el premio Nacional de Investigación en Matemáticas y TIC.

¿En qué trabaja un equipo científico como el que usted dirige con el llamativo nombre de grupo de arquitecturas paralelas? Trabajamos en lo que hay detrás de las cortinas de Internet. Internet es una red que ofrece servicios, y para dar esos servicios, además de que haya una red de comunicaciones, hacen falta unos servidores. Los servidores son los que alojan y procesan la información, son los que ejecutan las aplicaciones que nos da Internet y, por tanto, son su núcleo fundamental. Podemos hacer un símil con las carreteras y las ciudades. ¿De qué serviría la red de carreteras si no existiesen las ciudades y los pueblos? Nosotros trabajamos en mejorar esos servidores.

¿Por qué hace falta mejorarlos si ya nos dan un buen servicio?

Porque el número de clientes va creciendo constantemente y la sofisticación de los servicios que ofrecen también. Por tanto, hace falta más potencia, más capacidad.

¿Cómo se les procura más capacidad a los servidores?

Hubo un momento en el que se decidió, por cuestiones económicas, que los servidores debían estar constituidos por los mismos procesadores que usamos en un portátil o en un ordenador de sobremesa y que debían tener muchos de esos procesadores. Es como un motor con muchos cilindros, en lugar de tener uno solo. La clave está en que todos esos procesadores tienen que estar conectados entre sí, y a medida que vamos poniendo más y más procesadores para aumentar la potencia, se va haciendo más complicado interconectarlos de forma eficiente.

Ahí es donde entra su grupo. Sí. En lo que más hemos trabajado ha sido en la interconexión de esos procesadores, y en cómo mejorarla ofreciendo nuevas topologías de interconexión, aportando técnicas para encontrar el camino más eficiente para los paquetes de información. Estudiamos cómo hacer las redes más fiables, cómo reducir el consumo de energía de los servidores y cómo gestionar las situaciones en las que la Red se colapsa porque hay demasiado tráfico y cómo prevenir ese colapso. En el aspecto personal, ahora también estoy centrado en la transferencia de tecnología, en cómo hacer que nuestros resultados lleguen a las empresas y se puedan traducir en algo útil.

¿Ha conseguido algo en el campo de la transferencia?

El supercomputador que durante cuatro años fue el más potente del mundo, el BlueGene/L de IBM, con 64.000 procesadores. ¿Cómo los interconectamos? Pues los ingenieros de IBM encontraron una forma que consideraron bastante conveniente. Es una estructura tridimensional en la que cada uno de los procesadores comunica únicamente con seis vecinos. Entonces, para hacer llegar un paquete de información a un nodo que no está directamente conectado, ¿qué ruta sigue? Podrían haber hecho que recorriera siempre la misma ruta para ir de un sitio a otro, pero eso quiere decir que si hay otros paquetes que siguen un camino que sea parte de esa misma ruta, colisionan. Por tanto, sería mejor enviarlo por otra vía. Pero si se hace eso sin cuidado, o necesitas muchos recursos o se puede colapsar la Red. Yo desarrollé una teoría que garantizaba que aquello no se podía colapsar totalmente, y con muy pocos recursos adicionales. Los de IBM encontraron muy interesante esta contribución y la aprovecharon para hacer el diseño. En concreto, en lugar de necesitar un número de recursos que crecía exponencialmente con el número de dimensiones de la red (en este caso eran tres), en mi teoría no crecía exponencialmente, sino que era constante e igual a 1. Es decir, un cambio radical. Hay otros resultados que estamos llevando a empresas. Hacemos un esfuerzo por contactar con ellas para mostrarles en qué trabajamos, para aprender cuáles son sus necesidades y, a partir de ahí, hacer desarrollos específicos para esas empresas.

¿Es una demanda que no cubren los propios ingenieros de las empresas? Las empresas grandes tienen sus departamentos de I+D, pero eso no quiere decir que ellos puedan encontrar todas las soluciones o que sean las mejores. Por ejemplo, en el caso del supercomputador de IBM, se podría haber seguido una ruta fija para todos los paquetes, un origen y un destino, y habría funcionado correctamente, pero las prestaciones no habrían sido las mismas. Gracias a nuestra contribución, prácticamente con el mismo coste, las prestaciones de la máquina aumentaron.

Hallar soluciones innovadoras donde otros sólo ven callejones sin salida debe de requerir mucha imaginación. ¿Cuál es el papel de la creatividad en la labor del científico? La creatividad es fundamental, pero no es algo para lo que se tenga una fórmula mágica. Hay una serie de pasos que son absolutamente imprescindibles. Si no se tiene una buena base científica sobre un tema es difícil ser creativo, porque no se tienen los conocimientos. Por tanto, un primer paso es adquirir una buena base de conocimientos en el campo en el que se quiera producir algún tipo de resultado. Eso es imprescindible, pero no suficiente. No sé cómo se consigue la imaginación; lo que sí sé es que se desarrolla. No sé cuál es el punto de partida, pero si practicamos, si ejercitamos la mente, también se desarrolla la capacidad de razonamiento y la creatividad. A base de practicar, al final acabas teniendo una cierta creatividad. Unos podrán llegar más lejos, otros menos, pero si no lo ejercitas, si no lo intentas desarrollar, no llegas nunca. Cuando tienes una buena base de conocimientos y ejercitas la creatividad, más tarde o más temprano se te ocurrirá algo.

“SI EJERCITAMOS LA MENTE, TAMBIÉN SE DESARROLLAN LA CAPACIDAD DE RAZONAMIENTO Y LA CREATIVIDAD. Y, A BASE DE PRACTICAR, AL FINAL ACABAS TENIENDO UNA CIERTA CREATIVIDAD”

Vale, practicar. ¿Y qué más? Hay que buscar oportunidades. Si desarrollamos algo basándonos en los conocimientos que hemos adquirido leyendo lo que han publicado otros científicos, sólo tendremos el punto de vista académico. Si las hipótesis de partida de otros académicos no eran correctas, si los modelos que utilizan no representan la realidad, lo que se nos ha ocurrido puede ser muy creativo, pero puede no servir para nada. Nosotros nos acercamos a las empresas, vemos las restricciones tecnológicas del momento, estudiamos las tendencias de mercado y detectamos en qué líneas se necesitan nuevas soluciones. A partir de ahí, intentamos ser creativos, pero no de una forma genérica, sino centrándonos en aquellas líneas que vemos que tienen interés.

¿Las otras disciplinas científicas o artísticas sirven de inspiración para la arquitectura computacional? Hay grupos de informáticos que buscan soluciones inspiradas en la biología, soluciones bioinspiradas. Nosotros no lo hacemos porque la tecnología es totalmente distinta, y a veces pretender replicar lo que se hace en una tecnología en otra tecnología distinta puede llevar a resultados bastante pobres. Hemos buscado analizar la tecnología que tenemos entre manos y ver qué es lo más efectivo que se puede hacer con ella. Ahí hay quien dice que tienes que salir fuera de la caja para poder verlo bien. Como dicen los anglosajones “think out of the box”; es decir, sal fuera y míralo desde otra perspectiva. Pero, en ese mirar desde otra perspectiva, de nuevo, mucha gente lo intenta, pero muy poca gente lo consigue. Cuando sales fuera, o tienes una visión de conjunto o no ves nada. Por eso, es muy importante contactar con las empresas, hacerte una visión global que tiene que incluir tendencias de mercado, limitaciones tecnológicas, estado actual de la investigación en ese campo.

Think different, como rezaba el famoso eslogan de Apple.

A veces, retomamos soluciones que se plantearon hace mucho tiempo, cuando todavía no era el momento adecuado, pero que ahora puede que sí. Lo que hacemos también mucho es partir de hipótesis diferentes. Si a lo mejor cambias la tecnología o el planteamiento de partida puedes sacar resultados mejores. Casi nadie se plantea eso. Casi todos parten de las mismas bases e intentan mejorarlo. Si partes desde otro punto de vista totalmente distinto es posible que se te ocurra algo mejor.

¿Quiénes son los mejores haciendo eso en arquitectura computacional? No para la comunicación, sí para la inteligencia artificial. Se ha analizado mucho el funcionamiento de las neuronas, se han hecho modelos, se han conectado estos y han formado una cosa a la que en su momento se le dio el nombre de redes neuronales. Fundamentalmente, las redes neuronales se utilizan en el campo de la inteligencia artificial para reconocimiento de patrones, etcétera.

¿Y en su campo? En cuanto a aprender de las redes neuronales para mejorar la interconexión entre procesadores, de nuevo, son tecnologías distintas y creo que no tiene sentido. De entrada, las redes con las que nosotros estamos trabajando requieren decenas de nanosegundos para cruzar un dispositivo y, como mucho, unos pocos centenares de nanosegundos para ir de un procesador a otro. Cuando hablamos de neuronas estamos hablando de milisegundos; es decir, de algo que es más de 10.000 veces más lento. El planteamiento es muy distinto. Por otro lado, las neuronas tienen conexiones de mucha más larga distancia y eso, cuando trabajamos a baja frecuencia, es aceptable, pero cuando trabajamos con las frecuencias de gigahercios que trabajamos nosotros no lo es porque distancias más largas significan una capacidad parásita más alta y mucho más consumo de energía. Vemos el ejemplo de las neuronas en el cerebro, pero, al mismo tiempo, vemos las limitaciones cuando se quiere trabajar a muy alta velocidad. Por tanto, tenemos que buscar otros modelos que sean más efectivos.

¿Hay límites físicos que no se podrán superar? Sí, por supuesto. El límite absoluto en estos momentos es la velocidad de la luz. No podemos enviar una información de un lugar a otro más rápido que la velocidad de la luz. Nos puede parecer que esta es rapidísima, y no está tan lejos. Hoy en día tenemos procesadores que funcionan a varios gigahercios de frecuencia. Incluso si fuera un gigahercio, significa que un ciclo de reloj dura sólo un nanosegundo. ¿Cuánto trozo recorre una señal eléctrica en un nanosegundo? A 300.000 kilómetros por segundo, nos da para 0,3 metros. Estamos hablando de distancias muy cortas. Funcionamos ya a unas frecuencias en que la distancia que puede recorrer la luz es muy corta, no llega ni a un metro. Y eso sin tener en cuenta nada más. Cuando comenzamos a incluir la resistencia de las pistas de cobre, la capacidad parásita, la velocidad es mucho más lenta. Por tanto, ahí tenemos un límite impresionante.

¿Alguno más? La disipación de calor. Eso ha hecho que los procesadores limiten su frecuencia por debajo de los cuatro gigahercios. Se puede llegar más allá, pero los procesadores se calientan mucho. En estos momentos, la densidad de producción de calor de un procesador actual es parecida a la de una central nuclear. Y evacuar esa cantidad de calor es difícil.

O sea, que llegará un momento en el que un grupo de investigación como el suyo se quedará sin trabajo. No, ahora explicaré por qué. Hemos hablado de la velocidad de la luz, de la capacidad parásita, de la limitación en la frecuencia, de la disipación de calor y, después, hay otra limitación importante: a medida que vamos haciendo los transistores más pequeños podemos meter más transistores en un chip, pero llegará un momento en el que no los podremos hacer más pequeños porque aparecerán efectos cuánticos muy significativos y dejarán de funcionar. Por tanto, dentro de poco llegaremos al límite máximo de transistores que podemos meter dentro de un chip. Todo eso limita la potencia máxima de cálculo que puede tener un chip.

¿Qué se puede hacer? Poner más chips. Si no podemos poner todo lo que queramos en un chip, ponemos varios chips y los interconectamos. Precisamente, es ahí donde nuestro grupo puede aplicar toda la investigación en enrutamiento y comunicación entre procesadores.

¿Y qué hay del ordenador cuántico? Cuando ya no podamos ir más allá, tendremos que buscar otra tecnología que pueda conseguir más densidad. Si en lugar de tener que diseñar transistores, que requieren muchos átomos para construirlos, pudiéramos desarrollar una unidad que hiciera algún tipo de cálculo útil que sólo requiriera un átomo o algo más pequeño (un fotón o algo así), podríamos hacer ordenadores más compactos. Es una forma de ir más allá de las limitaciones de la tecnología actual. La mecánica cuántica tiene unas propiedades que harían que un ordenador cuántico, en lugar de calcular la solución para un valor de los datos de entrada, calcularía al mismo tiempo la solución para todos los valores de los datos de entrada. Y eso haría que fuera muy útil, por ejemplo, en criptografía para descifrar claves; porque de esa forma, en lugar de probar si una clave es la que cumple las condiciones, podría probar con todas las claves al mismo tiempo y encontraría mucho más rápidamente la clave que se está utilizando. Por lo demás, aún son sistemas experimentales, con unas pocas unidades de procesamiento. No estamos hablando de miles de millones de transistores como tenemos en un chip actual. Es decir, incluso si llegamos a un momento en el que la tecnología cuántica funciona, para poder conseguir las densidades de integración que tenemos en la tecnología del silicio podemos necesitar unas cuantas décadas.

Algunos han propuesto que si no somos capaces de resolver muchas de las cuestiones más complejas en ciencia no es por una incapacidad ontológica, sino por desconocimiento de la gran cantidad de información que interviene y la dificultad para procesarla. ¿Cree que el aumento de la rapidez y potencia de las redes computacionales permitirá expandir los límites de la ciencia? Sí. El objetivo inicial del BlueGene/L era tener un supercomputador lo más potente posible para aplicaciones de cálculo del plegamiento de proteínas. Sabemos bastante de cómo funcionan los sistemas biológicos, pero aún queda mucho por descubrir. Sabemos que tiene mucho que ver la disposición espacial de los diferentes átomos de las moléculas. Hemos visto que todas las cadenas de genes, de proteínas, son cadenas lineales; no son cadenas ramificadas más complicadas. No, son muy sencillitas, formadas por una serie de aminoácidos que se repiten según un patrón u otro. Pues bien, las propiedades vienen de cómo esas cadenas lineales se pliegan. Y en función de cómo se pliegan adquieren una forma que permite o no engancharse con otras cadenas y reaccionar. Por tanto, es muy importante modelar correctamente ese plegamiento y poder hacer simulación de plegamiento de cadenas muy largas durante un espacio de tiempo suficientemente grande para ver qué forma adquiere aquello. El BlueGene/L es el primer computador que se ha diseñado con ese objetivo. No tiene la potencia suficiente para calcular el plegamiento de una proteína compleja en un tiempo razonablemente corto, pero es un primer paso.

“EN ARQUITECTURA COMPUTACIONAL, EL PAÍS MÁS AVANZADO CON DIFERENCIA ES ESTADOS UNIDOS. EN EUROPA LA SITUACIÓN NO ES DE LO MÁS BRILLANTE. TENEMOS SÓLO UNA EMPRESA FRANCESA PUNTERA EN SUPERCOMPUTACIÓN”

Pero ¿le ve futuro a esa aplicación? Los supercomputadores van a contribuir a que podamos modelar la realidad física y química y, a partir de ahí, hacer análisis mucho más sofisticados. La gran ventaja de la simulación respecto a todas las pruebas de laboratorio es que cuando tenemos un sistema real no podemos medirlo absolutamente todo, y, por tanto, hay muchas cosas que no podemos controlar simplemente porque no se pueden medir. Mientras que en el modelo de simulación, aunque es una representación simplificada de la realidad, como estamos haciendo la simulación en un pro-grama que desarrollamos nosotros, podemos medirlo todo, podemos tirar hacia adelante, podemos reproducir otra vez la parte que nos interesa, etcétera. Todas esas características que permite la simulación no las tenemos en un laboratorio.

Estamos viviendo la emergencia de la computación en nube y de muchas aplicaciones vía Internet. ¿Habrá capacidad de procesamiento por parte de los servidores? ¿Se puede dar un colapso de Internet por una explosión de aplicaciones? Puede darse, tanto en el ancho de banda de las redes como en la capacidad de procesamiento y almacenamiento de los servidores. Precisamente, por eso estamos trabajando en mejorar su escalabilidad.

¿Puede Europa reducir la dependencia tecnológica respecto de EE UU? No es fácil competir con multinacionales. La única oportunidad la tenemos ahora. Dado que no podemos seguir aumentando las prestaciones de un núcleo de procesamiento porque se calienta demasiado, lo que tenemos que hacer es ir a chips con varios núcleos de procesamiento. Cuando vamos a chips con varios núcleos, podemos tener unos pocos núcleos muy potentes o muchos de menos potencia. Como en Europa tenemos empresas que diseñan los chips para telefonía móvil y aplicaciones parecidas, podríamos pensar en hacer un chip en el que tuviéramos muchos de estos procesadores más sencillos. Podríamos tener la misma o más potencia de cálculo que los procesadores que hace Intel y AMD. Serían más difíciles de programar, porque cuantos más núcleos tenemos, más complicada resulta la programación, pero podríamos tener una oportunidad para fabricar servidores con procesadores europeos. El problema es que serían máquinas que tendrían muchos procesadores interconectados, y la cuestión de la interconexión no es trivial, pero ahí podríamos ayudar nosotros. Hay una oportunidad. ¿La aprovecharán las empresas europeas? Está por ver.

MUY PERSONAL

¿Hay algún científico o ingeniero que le haya servido de inspiración?

Voy adaptando mi forma de proceder de forma continua, en función de lo que aprendo de los demás y también en función de las necesidades y oportunidades que se presentan. Dicho esto, las dos personas que en su momento tuvieron una influencia más profunda sobre mí fueron el profesor Mateo Valero, de la Universidad Politécnica de Cataluña, y el profesor William Dally, del MIT y ahora en la empresa Nvidia). El primero me abrió los ojos a una forma diferente de enfocar la investigación, más en línea con lo que se hacía en el ámbito internacional, y el segundo me ha servido de referencia durante años.

A usted, ¿no le ha tentado ninguna Universidad potente o alguna multinacional?

No sólo he tenido ofertas, sino que me han evaluado en secreto para alguna plaza, en concreto para una universidad de EE UU al más alto nivel.

¿Y por qué no aceptó?

Por muchos motivos. Fundamentalmente, porque a la familia me la llevé allí un par de meses y nos les gustó, no les pareció bien la idea de ir a vivir a EE UU. Y después, por otro lado, aunque allí tenía un sueldo cuatro veces mayor, aquí tenía a mi gente, a mi grupo de investigación, al cual no quería dejar. También tenía la impresión de que España iba a mejorar, y, efectivamente, ha mejorado mucho.

¿Dios es un supercomputador?

Por supuesto que no. Los supercomputadores son una creación de la raza humana, como lo son los coches, aviones y teléfonos móviles. Nada que ver con Dios. Ni siquiera son capaces de pensar como lo hacemos los humanos.

¿Tiene alguna solución el dilema entre los derechos de autor y las descargas de archivos en Internet?

Igual que se pueden encriptar mensajes para una transmisión segura, que son muy difíciles de descifrar, se pueden encriptar los contenidos digitales, con claves aún más largas si hace falta.

¿Adónde cree que nos conducirá la revolución digital como sociedad?

Las posibilidades son inmensas, porque no depende ya tanto del desarrollo de nuevas tecnologías como de la imaginación para combinar tecnologías ya existentes o que se pueden desarrollar fácilmente. Continuamente, se anuncian nuevos avances, que son casi siempre resultado de estas combinaciones.